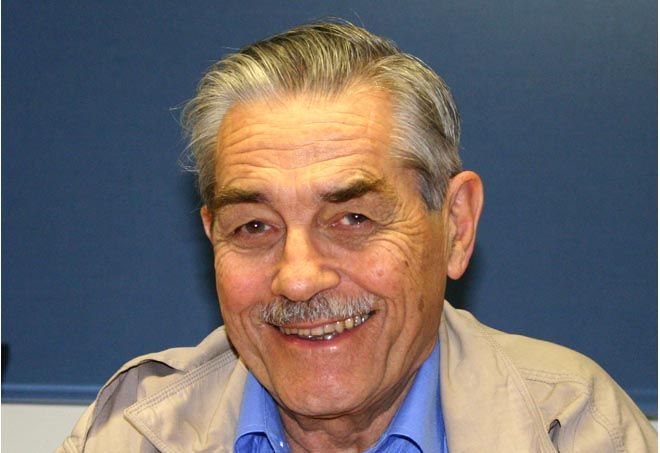

Louis Pouzin. Quarante ans après ses débuts, l’Internet pourrait se doter d’une architecture à bulles

Propos recueillis par Thérèse Bouveret.

Cet étonnant chercheur qui n’a rien perdu de sa verdeur revient sur l’histoire de la création de l’Internet dont il a été l’un des acteurs. Il veut relancer un nouveau projet baptisé « Renaissance ».

Place Publique : Vous avez participé aux débuts de l’Internet dans les années 1970 et notamment au sein du projet expérimental Cyclades. Vous avez conçu l’architecture de l’Internet qui reposait sur les datagrammes et qui a été reprise après, au sein de l’ARPANET américain, par des chercheurs comme Bob Kahn qui ont promu le concept de TCP (Transmission Control Protocol)./ IP. Pouvez-vous en dire plus ?

Louis Pouzin : C’est une question de timing. J’ai commencé à travailler sur les réseaux, fin 1971 quand j’ai été embauché à la délégation à l’informatique. J’ai d’abord recruté une équipe (ce qui a pris 3 à 4 mois). J’avais beaucoup lu sur ce qui se faisait sur les réseaux parce que j’étais un ancien des operating systems mais il n’y avait pas grand chose à l’époque : une dizaine d’articles à peine. Il y avait bien le réseau ARPA (Advanced Research Projects Agency) du département de la Défense, le réseau de Tymnet et le réseau SITA des compagnies aériennes. Les trois techniques étaient très différentes. Celle du réseau Arpa était plus intéressante et les chercheurs publiaient tout ce qu’ils faisaient. Après, j’ai fait un tour aux Etats-Unis, j’ai visité quelques sites de l’Arpa et des sociétés industrielles pour voir ce qui se faisait dans le domaine des ordinateurs interconnectés. On ne parlait pas encore de réseaux de paquets, la terminologie n’existait pas. Le terme de « paquet » avait été introduit quelques années plus tôt par Donald Davies, un chercheur qui était responsable du laboratoire au National Physical Laboratory. La manière dont les américains construisaient Arpanet ne me paraissait pas adaptée pour la France. D’une part, il fallait utiliser des matériels et des logiciels qui n’étaient pas sur le marché, ça introduisait un élément supplémentaire de difficulté, et de plus il était hors de question en France de pouvoir modifier les matériels des constructeurs comme celui d’IBM, par exemple.

P.P. : Comment vous-y-êtes vous pris ?

L.P. : Je suis parti sur une une autre voie : faire du standard constructeur pour commencer mais uniquement pour les interfaces de communication entre les ordinateurs et le réseau. Le réseau Arpa lui-même, ne me paraissait pas trop efficace, beaucoup trop inspiré par ce qu’avait fait Tymnet ou la Sita : des circuits virtuels. On envoyait des morceaux de données, qu’on appelait paquets, sur des systèmes de transmission qui fonctionnaient comme un circuit téléphonique et qui arrivaient en séquence à l’autre bout, comme les wagons d’un train. Les techniques de correction d’erreurs me paraissaient insuffisantes. Le réseau Arpa était conçu pour être seul au monde et non pour être connectés à d’autres. C’était la première hérésie. La deuxième hérésie : le réseau n’était pas censé faire d’erreur, il n’y avait aucun contrôle entre les émetteurs et les autres récepteurs. Il faut faire plus simple, plus sûr.

Comme j’étais informaticien je n’avais pas de contrainte mentale, à la différence des ingénieurs telecom, je n’étais pas obsédé par le fait qu’il faut un canal entre deux interlocuteurs avant qu’ils puissent échanger quoi que ce soit. Mon idée était d’envoyer des paquets qui se débrouillaient comme ils pouvaient ; et de mettre des contrôles d’erreur ou de flux pour s’assurer que le récepteur ne soit pas noyé par ce qu’envoie l’émetteur. Ce n’était pas des techniques nouvelles mais elles n’avaient pas été expérimentées et personne ne pouvait dire comment ça marchait.

Place Publique : Qu’est-ce qui se passe si on envoie trop de paquets ?

L.P. : Après avoir bien regardé les travaux de simulation du National Physical Laboratory, je suis parti sur une idée : envoyer les paquets comme ils peuvent et derrière mettre un contrôle d’erreur. Quand il y a trop de paquets, on en jette. Pour nous jeter des paquets n’avait rien de scandaleux puisque nous avions des protocoles pour corriger les erreurs. Il restait à convaincre le monde entier, le monde de ceux qui étaient dans ces projets en France, c’est à dire à l’époque la délégation à l’informatique et la DRME (la partie de l’armée qui finançait la recherche) et les PTT pour avoir des lignes gratuites.

P.P. : Votre projet était en concurrence avec celui du CNET ( Centre National des Télécommunications) ?

L.P. : Il y avait un réseau expérimental au CNET. La Délégation à l’Informatique n’en avait pas entendu parler pour la bonne raison qu’ils utilisaient du matériel américain DEC (racheté par Dell ensuite) au lieu du matériel français C2I. Bien sûr, nous avons pris du matériel C2I, bien sûr, l’avantage c’est qu’ils nous prêtaient du monde : un ingénieur et demi, ce qui n’est pas négligeable vu que nous étions 5 ou 6 à l’époque. Nous sommes partis là-dessus. Au départ il n’y avait pas de spécifications bien définies pour le réseau. Le CNET pensaient que nous allions prendre leur réseau mais il ne nous convenait pas parce qu’il était complètement circuit virtuel. Il était orienté transmission basse vitesse plutôt pour les terminaux.

Pour le CNET, l’objectif n’était pas de faire communiquer les ordinateurs entre eux mais plutôt de permettre à des terminaux de se connecter à des réseaux de données (télex moderne) . J’ai créé un réseau de transmission de données qui s’appelait Cigale. Il y a eu un peu de tirage. Le CNET voulait bien réaliser ce réseau mais à condition d’avoir le choix du matériel. Autrement dit, ils voulaient continuer leur propre projet. Comme ils étaient politiquement très puissants, je me suis dit que si nous étions d’accord avec cette approche, nous allions perdre du temps. Nous avons décidé de continuer sur notre idée. Mon patron de l’époque à L’IRIA, Michel Monpetit (qui malheureusement a été tué dans un accident de voiture quelques années plus tard) a négocié avec le CNET. Il les assurait que nous utiliserions leur réseau quand il serait prêt mais que, comme nous étions pressés, nous utiliserions un réseau de paquets pour aller plus vite. Nous sommes donc partis sur ces bases là pas tout à fait sincères parce que nous pensions que nous irions plus vite. Un an plus tard, nous avons fait la démonstration devant toute la « nomenclatura » de l’époque (Délégation à l’informatique, ministre des PTT etc..) que le réseau Cyclades marchait. Certes pas très bien mais nous avions réussi à faire un transfert de fichiers vers Grenoble avec exécution de fichiers et retour des résultats à l’IRIA. Il n’y avait pas eu de précédent. Nous avons donc continué. La C2I était très en faveur de notre projet parce que nous utilisions leur matériel et, d’autre part, parce que ça lui permettait de le commercialiser dans un avenir proche.

P.P. : Quel était votre budget ?

L.P. : Nous avions quelque chose comme 25 millions de francs de 1973 et nous en avons dépensé 23,5. Le projet a coûté près du double en comptant les gens payées par la C2I, ou prêtées par les universités (Grenoble, Lille, Rennes, Nancy, Strasbourg etc…) : soit une quarantaine de personnes. Comme j’avais un budget et qu’il n’y avait pas poste libre dans l’administration, je louais des ingénieurs aux sociétés de service françaises ( la SEMA, la SACS, Cap Sogeti). Une collaboration très fructueuse puisque que nous avons formés aux réseaux, pendant un an, les ingénieurs qu’ils ont mis à notre disposition et ont pu revendre ensuite sur le marché. Un transfert de technologie beaucoup plus rapide que par les voies traditionnelles. A la mort de Pompidou, à la suite du changement de politique en France, le programme a été arrêté.

P.P. : C’est à ce moment là que les américains, ayant eu vent de vos travaux, sont venus vous voir ?

L.P. : En 1973, Bob Khan Khan et Vinton Cerf sont passés nous voir. Comme j’avais une culture américaine parce que j’avais étudié au MIT (Massachusets Institute of Technology), je savais qu’il fallait publier et je parlais anglais. J’ai commencé à publier fin 1972 sur l’architecture générale de Cyclades dans une conférence aux Etats-Unis, ce qui a commencé à attirer l’attention. (Nous avions déjà publié sur l’architecture mais pas de la manière dont ça devait fonctionner). Un certain nombre de leurs collègues américains trouvaient que nos techniques étaient intéressantes et poussaient l’ARPA à examiner si ce n’était pas intéressant de changer les leurs. Bob Kahn et Vinton Cerf sont donc venus nous voir et sont aussi allés au CNET ( ce n’était pas encore X 25, mais un réseau de circuit virtuel pas encore opérationnel). Nous leur avons expliqué comment nous nous y prenions. Ils nous ont posé un tas des objections techniques auxquelles nous avions déjà répondu dans la pratique. Et six mois plus tard, en 1973, lors d’un workshop (séminaire essentiellement constitués de gens qui étaient des activistes dans les réseaux, Barry Wesler etc) qui se déroulait à Brighton, une petite ville de la côte sud de l’Angleterre, Bob Kahn a présenté, de manière tout à fait informelle, la première tentative de TCP-IP (Il ne l’avait pas encore implémentée). Il n’a d’ailleurs pas reçu un grand enthousiasme. L’année suivante, il a publié officiellement son article.

P.P. : C’est à dire en 1974, ils ont publié un papier et vous aussi, vous avez publié un article sur les datagrammes, cette année là.

L.P. : Oui, c’était à la même conférence à l’ICCC à Stockholm, nous avons publié notre papier sur Cigale mais alors que nous décrivions ce qui était déjà en marche chez nous, ils ont publié leur draft sur TCP/IP

P.P. : Ils ont donc repris vos idées ?

L.P.: Oui, ils ont repris les même principes, le protocole entre ordinateurs qui avait été finalisé pour Cyclades par Hubert Zimmermann, mort en octobre dernier, et Jean-Louis Grangé. C’était une technique confidentielle que je connaissais déjà puisqu’elle était utilisée de manière primaire dans les réseaux de communication pour des compagnies aériennes. J’avais obtenu des papiers internes par des collègues, il n’y avait aucune publication concernant ces protocoles propriétaires utilisés de manière réduite (OACI ou ICAO ). J’ai considéré que c’était beaucoup plus souple et pratique. A l’époque, on envoyait un paquet et on attendait l’accusé de réception avant d’en envoyer un autre, ce qui faisait perdre du temps. L’idée, c’était d’envoyer une série de paquets et, à l’arrivée, on voyait sur l’accusé de réception ceux qui étaient arrivés ou pas, et on renvoyait ceux qui n’étaient pas acquittés. Ce protocole a été un peu bricolé par Bob Kahn et Vinton Cerf. Ils l’ont changé notamment avec des tailles d’adressage plus importantes (encore insuffisantes pour l’ARPA cependant). Nous avions mis une adresse de 8 bits, c’était largement suffisant pour notre réseau qui comprenait 32 ordinateurs. Par ailleurs, ils ont introduit une technique (avec laquelle je n’étais pas d’accord) qui fragmentait les paquets en route si nécessaire pendant leur trajet. En effet, dans la mesure où on interconnecte plusieurs réseaux, il n’est pas possible de bien connaître la taille de paquets qui va être acceptable. A la destination, on va rassembler tout ça. Ça marche mais avec quelques erreurs. En particulier, ça ne permet pas de livrer des paquets par deux ou plusieurs points de sortie (dual homing) parce qu’on ne sait plus très bien à quelle communication appartiennent ces fragments. De de fait, l’Internet actuel a toujours été incapable de faire du dual homing, ce qui gêne beaucoup les opérateurs. Bob Kahn et Vinton Cerf ont donc introduit quelques modifications de ce style mais dans le fond c’est le même principe.

P.P. : Entre les débuts de l’Internet et maintenant, que s’est-il passé ?

L.P. : A partir du moment où le financement de Cyclades a été interrompu, les ingénieurs de mon équipe à l’IRIA ont continué à fonctionner sur fonds propres pendant quatre ans, jusqu’en 1978. J’ai été responsable des différents projets pilotes financés de l’IRIA et je les ai supervisés : Unix en Pascal, robotique, par exemple… Après, il y a eu le deuxième chambardement : la suppression de l’IRIA remplacée par l’INRIA (Institut National de l’Informatique et des Automatismes). La délégation à l’informatique avait été supprimée en 1974. Le gouvernement de l’époque comptait éliminer tout ce qui était recherche en réseau et estimait que c’était à l’industrie de prendre le relai. L’agence de l’informatique a vu le jour en 1976 et a repris des ingénieurs (pas trop geek) de l’INRIA. Mon équipe était démantelée. J’ai refusé de suivre et j’ai été licencié.

P.P. : Vous avez ensuite participé aux travaux de normalisation ?

L.P. : Oui, du temps de l’IRIA j’avais participé aux travaux des différents groupes de l’AFNOR (partie française de l’ISO (International Organization for Standardization). En 1976, l’ISO a créé la normalisation OSI (Open System InterConnexion). Mon équipe en est devenue l’acteur principal. Hubert Zimmermann est devenu un des piliers de l’architecture OSI. Ensuite, pour le CNET dans les années 1980, j’ai fait essentiellement de la normalisation à Bruxelles au sein d’un groupe European Communication basé à Sophia Antipolis dont le le but était d’élaborer des normes internet et télécom. Il n’y avait pas vraiment de consensus. Il fallait faire admettre au plan européen un certain nombre de normes qui fassent contrepoids aux normes propriétaires des industriels de l’informatique comme IBM. (Dans les années 1990, je suis devenu responsable de l’enseignement technologique à Theseus, toujours à Sophia Antipolis, pour donner une certaine culture des moyens de communication en pleine évolution aux cadres des grandes entreprises qui devaient intégrer les réseaux. Une activité d’enseignement qui a été reprise ensuite par ParisTech.)

P. P. : Il y a eu des lacunes à la création l’Internet qui n’ont pas été résolues quarante ans plus tard : le nommage, par exemple.

L.P. : en 1973, personne n’avait ni le temps ni les idées précises pour traiter ce genre de questions et, en effet, depuis ça n’a pas changé. Pour le nommage, il y a l’IPV4 qui est devenu trop étroit en partie à cause de l’absence de gestion sérieuse du système d’adresses. Au début, ils distribuaient des paquets de 16 millions d’adresses à des gens qui n’en avaient pas besoin. Les Etats-Unis se sont attribués la part de lion, soit 45 % de l’espace IPV4, ce qui est abusif parce qu’ils ne représentent pas la moitié du monde en matière d’ordinateurs.

P.P. : Les noms de domaine sont apparus bien plus tard ?

L.P. : Ils sont venus dix ans après. Ce qui est apparu plus tôt c’est le DNS, en 1983. Auparavant, les noms de domaine étaient attribués gratuitement. Les gens demandait des noms, Jon Postel, qui s’occupait de ça directement, les distribuaient à coût fixe. Ensuite Network Solutions (Netsol) l’a fait aussi, au début gratuitement puis pour une somme modique de quelques dizaines de dollars, sans récurrence : un coût fixe. Puis Netsol a été racheté par Verisign et c’est devenu une vache à lait. Verisign a augmenté les prix, a introduit beaucoup de propagande pour les noms de domaine en organisant leur rareté avec un total déséquilibre entre ce qui lui est alloué par rapport au reste du monde. Cette société possède 87 % des noms de domaine (.net, .com) , là encore c’est la part du lion.

P.P. : L’ICANN (Internet Corporation for Assigned Names and Numbers) a été introduit en 1998 pour vendre des noms de domaine ?

L.P. : Non, pour coordonner tous les organismes qui s’occupaient techniquement de l’Internet. Ça comprenant l’IETF (Internet EngineeringTask Force) pour la standardisation, l’IANA (Internet Assigned Numbers Autority), créée par Jon Postel qui distribuait les adresses IP, et aussi des comités divers qui distribuent les ordres de protocoles (pour les transfert de fichiers et …). Un certain nombre des services spécialisés, au lieu d’être adressés par leur nom, sont attribués par une porte d’entrée. Ça n’existait pas dans Cyclades parce que je pensais que ça ne servait à rien, sauf à compliquer les choses, de s’occuper des portes d’entrée. L’ICANN a été créé pour coordonner ces différentes fonctions et pour distribuer les noms de domaine. Dans la pratique, ils s’occupent peu du reste et vendent surtout les noms de domaine qui leur rapportent beaucoup d’argent.

P.P. : L’attribution de Top Level Domains par l’ICANN, prévue depuis 2008, devrait leur rapporter beaucoup d’argent.

L.P. : Les TLD demandés par des groupes industriels ou des organisations ne sont pas encore attribués. Le prix d’accès est de 185 000 dollars pour faire la demande et ensuite 50 000 dollars par années de location.

P.P. : Vous avez lancé en 2012 un projet de programme de recherche intitulé Renaissance pour remédier à certaines failles de l’architecture de l’Internet qui existent toujours ?

L.P. : C’est un projet qui a démarré il y a quatre ans à l’Université de Boston dont le responsable est John Day. C’est le projet RINA. Les « bostoniens » travaillent, comme on faisait à l’époque de Cyclades, avec d’autres équipes des Universités de New York et de Chicago. Ils ont des crédits américains (de la National Science Fondation). En Europe, il y a trois laboratoires de recherche qui ont déjà travaillé à ce projet avec des crédits européens : le LIP 6 à l’Université Paris 6, une base à Irlande, à Waterford au sud de Dublin, et l’I2cat à Barcelone.

P.P. : Le projet Renaissance a été soumis à la commission européenne début 2012 ?

L.P. : Oui. Y participaient une quinzaine de laboratoires de recherche, sociétés industrielles, sociétés de service, les PTT portugais etc…. Le projet soumis a été considéré comme très bien placé par ses objectifs et la qualité et de la présentation. Il a été blackboulé par les experts. ça s’est arrêté là. Nul ne sait quand ça pourra repartir

P.P. : Le projet Renaissance consiste à construire un autre architecture de l’Internet ?

L.P. : Toute la partie actuelle qui est constituée de TCP-IP est remplacée par un nouvel ensemble de protocoles apportant toutes les fonctions absentes aujourd’hui : le nommage, le multilinguisme, la sécurité, la gestion de ressources, l’authentification, etc…Sept ou huit fonctions majeures qui aujourd’hui n’existent pas dans TCP-IP . Il serait donc possible de construire des applications comme si c’était un petit réseau isolé du reste du monde, dans sa bulle. C’est complètement logiciel, c’est à dire qu’on peut construire des réseaux virtuels avec des applications qui sont étanches par rapport à d’autres réseaux donc à très grande sécurité de fonctionnement pourvu qu’il n’y ait pas de bugs, bien sûr. A l’abri des interférences qui empoisonnent Internet et qui permettent aux pirates d’entrer dans le réseau. Cela permettrait d’isoler des mini applications, des réseaux petits ou grands…

P.P. : Comment différentes bulles pourraient-elles communiquer entre elles ?

L.P. : Elles s’envoient des messages pour proposer de communiquer ensemble, par l’intermédiaire d’un aiguilleur. Il faut connaître les noms de ceux auxquels vous envoyez les messages. S’il y a des sous-systèmes qui veulent communiquer entre eux, il faut qu’ils déclarent leur nom. Une fois que tous les contrôles de mise en contact ont été établis, une nouvelle bulle de contact est créée qui englobe le tout. Les réseaux n’ont pas besoin de faire des chinoiseries pour communiquer entre eux.

P.P. : Vous avez chiffré ce programme, estimé le nombre de personnes nécessaires. Qui pourrait prendre en charge un programme aussi ambitieux qui, selon vous, ne correspond pas à un saupoudrage de la recherche ?

L.P. Je propose que nous prenions plusieurs partenaires européens, 4 ou 5 acteurs industriels et laboratoires de recherche qui apportent 50 % des fonds nécessaires et nous demandons à l’Union européenne de nous procurer le reste. Ce serait très dommage de ne pas utiliser les compétences européennes dans le domaine.

P.P : C’est un projet de quel ordre ?

L.P. : Ce n’est pas une totalité de projet. C’est plutôt ce qu’il faudrait faire pour donner une première étape de crédibilité. Quelque chose qui marche et qui fasse tourner quelques applications. Ensuite, il faudra multiplier des applications, faire des mesures, des adaptations à l’existant. Enfin, le budget servira à financer les coûts de migration sur des années d’un système à l’autre.

P.P. : Vous considérez qu’un tel programme est vraiment nécessaire ?

L.P. : C’est un choix. Si nous ne le faisons pas, nous assisterons à la cacophonie des Google, Facebook, Twitter avec des principes, des techniques hétérogènes, c’est à dire une opacité complète en matière de sécurité.